Hadoop installieren: Einrichten eines Hadoop-Clusters mit einem einzelnen Knoten

Von unseren vorherigen Blogs an Sie müssen eine theoretische Vorstellung von Hadoop, HDFS und seiner Architektur haben.Aber zu bekommen Sie brauchen gute praktische Kenntnisse.Ich hoffe dir hätte unser vorheriger Blog auf gefallen Jetzt werde ich Sie durch das praktische Wissen über Hadoop und HDFS führen. Der erste Schritt ist die Installation von Hadoop.

Es gibt zwei Möglichkeiten, Hadoop zu installieren, d. H. Einzelner Knoten und Multi-Knoten .

Einzelknotencluster bedeutet, dass nur ein DataNode ausgeführt wird und alle NameNode, DataNode, ResourceManager und NodeManager auf einem einzelnen Computer eingerichtet werden. Dies wird zu Studien- und Testzwecken verwendet. Betrachten wir zum Beispiel einen Beispieldatensatz innerhalb einer Gesundheitsbranche. Um zu testen, ob die Oozie-Jobs alle Prozesse wie das Sammeln, Aggregieren, Speichern und Verarbeiten der Daten in einer richtigen Reihenfolge geplant haben, verwenden wir einen einzelnen Knotencluster. Es kann den sequentiellen Workflow in einer kleineren Umgebung einfach und effizient testen, verglichen mit großen Umgebungen, die Terabyte an Daten enthalten, die auf Hunderte von Computern verteilt sind.

Während in einem Cluster mit mehreren Knoten Es wird mehr als ein DataNode ausgeführt, und jeder DataNode wird auf verschiedenen Computern ausgeführt. Der Multi-Node-Cluster wird praktisch in Organisationen zur Analyse von Big Data verwendet. In Anbetracht des obigen Beispiels muss es in Echtzeit, wenn wir mit Petabytes an Daten arbeiten, auf Hunderte von Maschinen verteilt werden, um verarbeitet zu werden. Daher verwenden wir hier einen Multi-Node-Cluster.

In diesem Blog werde ich Ihnen zeigen, wie Sie Hadoop auf einem einzelnen Knotencluster installieren.

Voraussetzungen

- VIRTUELLE BOX : wird zur Installation des Betriebssystems verwendet.

- BETRIEBSSYSTEM : Sie können Hadoop auf Linux-basierten Betriebssystemen installieren. Ubuntu und CentOS werden sehr häufig verwendet. In diesem Tutorial verwenden wir CentOS.

- JAVA : Sie müssen das Java 8-Paket auf Ihrem System installieren.

- HADOOP : Sie benötigen das Hadoop 2.7.3-Paket.

Installieren Sie Hadoop

Schritt 1: Klick hier um das Java 8-Paket herunterzuladen. Speichern Sie diese Datei in Ihrem Home-Verzeichnis.

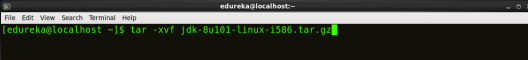

Schritt 2: Extrahieren Sie die Java Tar-Datei.

Befehl :: tar -xvf jdk-8u101-linux-i586.tar.gz

Abb: Hadoop-Installation - Extrahieren von Java-Dateien

Schritt 3: Laden Sie das Hadoop 2.7.3-Paket herunter.

Befehl :: wget https://archive.apache.org/dist/hadoop/core/hadoop-2.7.3/hadoop-2.7.3.tar.gz

Abb: Hadoop-Installation - Herunterladen von Hadoop

Schritt 4: Extrahieren Sie die Hadoop-TAR-Datei.

Befehl : tar -xvf hadoop-2.7.3.tar.gz

Abb: Hadoop-Installation - Extrahieren von Hadoop-Dateien

Schritt 5: Fügen Sie die Hadoop- und Java-Pfade in die Bash-Datei (.bashrc) ein.

Öffnen . bashrc Datei. Fügen Sie nun Hadoop und Java Path wie unten gezeigt hinzu.

Befehl :: vi .bashrc

Abb: Hadoop-Installation - Umgebungsvariable einstellen

Speichern Sie dann die Bash-Datei und schließen Sie sie.

Führen Sie den Quellbefehl aus, um alle diese Änderungen auf das aktuelle Terminal anzuwenden.

Befehl :: Quelle .bashrc

Abb: Hadoop-Installation - Aktualisieren von Umgebungsvariablen

Um sicherzustellen, dass Java und Hadoop ordnungsgemäß auf Ihrem System installiert wurden und über das Terminal aufgerufen werden können, zFühren Sie die Befehle java -version und hadoop version aus.

Befehl :: Java-Ausführung

Abb: Hadoop-Installation - Überprüfen der Java-Version

Befehl :: HadoopAusführung

Abb: Hadoop-Installation - Überprüfen der Hadoop-Version

Schritt 6 :: Bearbeiten Sie die .

Befehl: cd hadoop-2.7.3 / etc / hadoop /

wie man ein Ingenieur für künstliche Intelligenz wird

Befehl: ls

Alle Hadoop-Konfigurationsdateien befinden sich in hadoop-2.7.3 / etc / hadoop Verzeichnis, wie Sie im folgenden Schnappschuss sehen können:

Abb: Hadoop-Installation - Hadoop-Konfigurationsdateien

Schritt 7 :: Öffnen core-site.xml und bearbeiten Sie die unten genannte Eigenschaft im Konfigurations-Tag:

core-site.xml informiert den Hadoop-Daemon darüber, wo NameNode im Cluster ausgeführt wird. Es enthält Konfigurationseinstellungen des Hadoop-Kerns, z. B. E / A-Einstellungen, die für HDFS und MapReduce gelten.

Befehl :: vi core-site.xml

Abb: Hadoop-Installation - Konfigurieren von core-site.xml

fs.default.name hdfs: // localhost: 9000

Schritt 8: Bearbeiten hdfs-site.xml und bearbeiten Sie die unten genannte Eigenschaft im Konfigurations-Tag:

hdfs-site.xml enthält Konfigurationseinstellungen von HDFS-Dämonen (d. h. NameNode, DataNode, Secondary NameNode). Es enthält auch den Replikationsfaktor und die Blockgröße von HDFS.

Befehl :: vi hdfs-site.xml

Abb: Hadoop-Installation - Konfigurieren von hdfs-site.xml

dfs.replication 1 dfs.permission false

Schritt 9 :: Bearbeiten Sie die mapred-site.xml Datei und bearbeiten Sie die unten genannte Eigenschaft im Konfigurations-Tag:

mapred-site.xml Enthält Konfigurationseinstellungen der MapReduce-Anwendung wie die Anzahl der parallel laufenden JVM, die Größe des Mapper- und des Reduzierungsprozesses, die für einen Prozess verfügbaren CPU-Kerne usw.

In einigen Fällen ist die Datei mapred-site.xml nicht verfügbar. Also müssen wir die Datei mapred-site.xml erstellenVerwenden der Vorlage mapred-site.xml.

Befehl :: cp mapred-site.xml.template mapred-site.xml

Befehl :: wir mapred-Seite? ˅.xml.

Abb: Hadoop-Installation - Konfigurieren von mapred-site.xml

mapreduce.framework.name Garn

Schritt 10: Bearbeiten yarn-site.xml und bearbeiten Sie die unten genannte Eigenschaft im Konfigurations-Tag:

yarn-site.xml Enthält Konfigurationseinstellungen von ResourceManager und NodeManager wie die Größe der Anwendungsspeicherverwaltung, die für Programm und Algorithmus erforderliche Operation usw.

Befehl :: vi yarn-site.xml

Abb: Hadoop-Installation - Konfigurieren von yarn-site.xml

yarn.nodemanager.aux-services mapreduce_shuffle yarn.nodemanager.auxservices.mapreduce.shuffle.class org.apache.hadoop.mapred.ShuffleHandler

Schritt 11: Bearbeiten hadoop-env.sh und fügen Sie den Java-Pfad wie folgt hinzu:

hadoop-env.sh enthält die Umgebungsvariablen, die im Skript zum Ausführen von Hadoop verwendet werden, z. B. Java-Home-Pfad usw.

Befehl :: wir Hadoop- -env.Sch

Abb: Hadoop-Installation - Konfigurieren von hadoop-env.sh

Schritt 12: Gehen Sie zum Hadoop-Ausgangsverzeichnis und formatieren Sie den NameNode.

Befehl :: CD

Befehl :: cd hadoop-2.7.3

Befehl :: bin / hadoop Zweck-Format

wie man ein Array c ++ sortiert

Abb: Hadoop-Installation - Formatieren von NameNode

Dies formatiert das HDFS über NameNode. Dieser Befehl wird nur zum ersten Mal ausgeführt. Das Formatieren des Dateisystems bedeutet das Initialisieren des Verzeichnisses, das durch die Variable dfs.name.dir angegeben wird.

Formatieren und betreiben Sie niemals das Hadoop-Dateisystem. Sie verlieren alle Ihre im HDFS gespeicherten Daten.

Schritt 13: Sobald der NameNode formatiert ist, wechseln Sie in das Verzeichnis hadoop-2.7.3 / sbin und starten Sie alle Daemons.

Befehl: cd hadoop-2.7.3 / sbin

Entweder können Sie alle Dämonen mit einem einzigen Befehl starten oder einzeln ausführen.

Befehl: ./ start-all.sh

Der obige Befehl ist eine Kombination aus start-dfs.sh, start-yarn.sh & mr-jobhistory-daemon.sh

Oder Sie können alle Dienste einzeln wie folgt ausführen:

Starten Sie NameNode:

Der NameNode ist das Herzstück eines HDFS-Dateisystems. Es behält den Verzeichnisbaum aller im HDFS gespeicherten Dateien bei und verfolgt alle im Cluster gespeicherten Dateien.

Befehl: ./hadoop-daemon.sh Startzweck

Abb: Hadoop-Installation - Starten von NameNode

Starten Sie DataNode:

Beim Start stellt ein DataNode eine Verbindung zum Namenode her und antwortet auf die Anforderungen des Namenode für verschiedene Vorgänge.

Befehl: ./hadoop-daemon.sh startet den Datenknoten

Abb: Hadoop-Installation - Starten von DataNode

Starten Sie ResourceManager:

ResourceManager ist der Master, der alle verfügbaren Clusterressourcen vermittelt und somit bei der Verwaltung der verteilten Anwendungen hilft, die auf dem YARN-System ausgeführt werden. Seine Aufgabe besteht darin, jeden NodeManager und den ApplicationMaster jeder Anwendung zu verwalten.

Befehl: ./Garn-daemon.sh resourcemanager starten

Abb: Hadoop-Installation - Starten von ResourceManager

Starten Sie NodeManager:

Der NodeManager in jedem Maschinenframework ist der Agent, der für die Verwaltung der Container, die Überwachung ihrer Ressourcennutzung und die Berichterstellung an den ResourceManager verantwortlich ist.

Befehl: ./Garn-daemon.sh nodemanager starten

Abb: Hadoop-Installation - Starten von NodeManager

Starten Sie JobHistoryServer:

JobHistoryServer ist für die Bearbeitung aller Anforderungen an den Jobverlauf vom Client verantwortlich.

Befehl :: ./mr-jobhistory-daemon.sh Historyserver starten

Schritt 14: Führen Sie den folgenden Befehl aus, um zu überprüfen, ob alle Hadoop-Dienste ausgeführt werden.

Befehl: jps

Abb: Hadoop-Installation - Überprüfen von Dämonen

Schritt 15: Öffnen Sie nun den Mozilla-Browser und gehen Sie zu localhost :: 50070 / dfshealth.html um die NameNode-Schnittstelle zu überprüfen.

Abb: Hadoop-Installation - Starten der WebUI

Herzlichen Glückwunsch, Sie haben erfolgreich einen Hadoop-Cluster mit einem Knoten auf einmal installiert.In unserem nächsten Blog von Wir werden uns auch mit der Installation von Hadoop auf einem Cluster mit mehreren Knoten befassen.

Nachdem Sie die Installation von Hadoop verstanden haben, lesen Sie die von Edureka, einem vertrauenswürdigen Online-Lernunternehmen mit einem Netzwerk von mehr als 250.000 zufriedenen Lernenden auf der ganzen Welt. Der Edureka Big Data Hadoop-Zertifizierungskurs hilft Lernenden, Experten für HDFS, Garn, MapReduce, Schwein, Bienenstock, HBase, Oozie, Flume und Sqoop zu werden. Dabei werden Anwendungsfälle in Echtzeit in den Bereichen Einzelhandel, soziale Medien, Luftfahrt, Tourismus und Finanzen verwendet.

Hast du eine Frage an uns? Bitte erwähnen Sie es in den Kommentaren und wir werden uns bei Ihnen melden.