Der Umgang mit heterogenen Daten ist sicherlich eine mühsame Aufgabe, aber mit zunehmendem Datenvolumen wird es immer mühsamer. Hier helfen die ETL-Tools bei der Umwandlung dieser Daten in homogene Daten. Diese transformierten Daten sind nun einfach zu analysieren und die erforderlichen Informationen daraus abzuleiten. In diesem Blog über Talend ETL werde ich darüber sprechen, wie Talend außergewöhnlich als ETL-Tool funktioniert, um wertvolle Erkenntnisse aus Big Data zu nutzen.

In diesem Talend ETL-Blog werde ich die folgenden Themen diskutieren:

- Was ist der ETL-Prozess?

- Verschiedene ETL-Tools

- Talend ETL Tool

- Talend Open Studio: Ausführen eines ETL-Jobs

Sie können auch dieses ausführliche Video-Tutorial durchgehen, in dem unsere Der Experte erklärt Talend ETL und die Datenverarbeitung damit detailliert anhand klarer Beispiele.

Talend ETL Tutorial | Talend Online Training | Edureka

Was ist der ETL-Prozess?

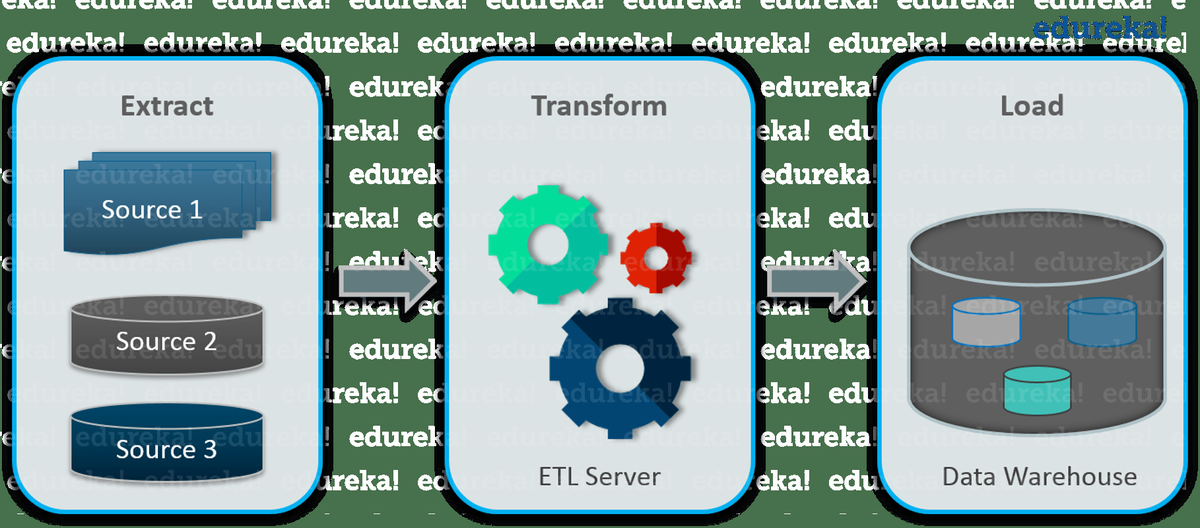

ETL steht für Extrahieren, Transformieren und Laden. Es bezieht sich auf drei Prozesse, die erforderlich sind, um die Rohdaten von ihrer Quelle in ein Data Warehouse oder eine Datenbank zu verschieben. Lassen Sie mich jeden dieser Prozesse im Detail erklären:

lerne pl sql online kostenlos

Extrakt

Das Extrahieren von Daten ist der wichtigste Schritt von ETL, bei dem auf die Daten aller Speichersysteme zugegriffen wird. Die Speichersysteme können RDBMS, Excel-Dateien, XML-Dateien, Flatfiles, ISAM (Indexed Sequential Access Method), hierarchische Datenbanken (IMS), visuelle Informationen usw. sein. Da dies der wichtigste Schritt ist, muss es so gestaltet werden dass es die Quellsysteme nicht negativ beeinflusst. Der Extraktionsprozess stellt außerdem sicher, dass die Parameter jedes Elements unabhängig von seinem Quellsystem eindeutig identifiziert werden.

Verwandeln

Transformation ist der nächste Prozess in der Pipeline. In diesem Schritt werden ganze Daten analysiert und verschiedene Funktionen darauf angewendet, um diese in das erforderliche Format umzuwandeln. Im Allgemeinen werden für die Transformation der Daten Prozesse konvertiert, gefiltert, sortiert, standardisiert, die Duplikate gelöscht, die Konsistenz verschiedener Datenquellen übersetzt und überprüft.

Belastung

Das Laden ist die letzte Phase des ETL-Prozesses. In diesem Schritt werden die verarbeiteten Daten, d. H. Die extrahierten und transformierten Daten, dann in ein Zieldaten-Repository geladen, bei dem es sich normalerweise um die Datenbanken handelt. Bei der Ausführung dieses Schritts sollte sichergestellt werden, dass die Ladefunktion genau ausgeführt wird, jedoch nur minimale Ressourcen verwendet werden. Außerdem müssen Sie beim Laden die referenzielle Integrität beibehalten, damit Sie die Konsistenz der Daten nicht verlieren. Sobald die Daten geladen sind, können Sie jeden Datenblock aufnehmen und einfach mit anderen Datenblöcken vergleichen.

Nachdem Sie nun den ETL-Prozess kennen, fragen Sie sich möglicherweise, wie Sie all dies durchführen sollen. Nun, die Antwort ist einfach mit ETL Tools. Im nächsten Abschnitt dieses Talend ETL-Blogs werde ich über die verschiedenen verfügbaren ETL-Tools sprechen.

Verschiedene ETL-Tools

Bevor ich jedoch über ETL-Tools spreche, sollten wir zunächst verstehen, was genau ein ETL-Tool ist.

Wie ich bereits besprochen habe, sind ETL drei separate Prozesse, die unterschiedliche Funktionen ausführen. Wenn alle diese Prozesse zu einem einzelnes Programmierwerkzeug Dies kann bei der Vorbereitung der Daten und bei der Verwaltung verschiedener Datenbanken hilfreich sein.Diese Tools verfügen über grafische Oberflächen, über die der gesamte Prozess der Zuordnung von Tabellen und Spalten zwischen den verschiedenen Quell- und Zieldatenbanken beschleunigt wird.

Einige der Hauptvorteile der ETL-Tools sind:

- Es ist sehr Einfach zu verwenden Dies macht das Schreiben der Prozeduren und des Codes überflüssig.

- Da die ETL-Tools GUI-basiert sind, bieten sie eine visueller Fluss der Systemlogik.

- Die ETL-Tools verfügen über eine integrierte Fehlerbehandlungsfunktion, über die sie verfügen operative Belastbarkeit .

- Beim Umgang mit großen und komplexen Daten bieten ETL-Tools a besseres Datenmanagement indem Sie die Aufgaben vereinfachen und Sie bei verschiedenen Funktionen unterstützen.

- ETL-Tools bieten im Vergleich zu herkömmlichen Systemen erweiterte Reinigungsfunktionen.

- ETL-Tools haben eine verbesserte Business Intelligence Dies wirkt sich direkt auf die strategischen und operativen Entscheidungen aus.

- Aufgrund der Verwendung der ETL-Tools kann die Aufwand reduziert viel und die Unternehmen sind in der Lage, höhere Einnahmen zu generieren.

- Performance der ETL-Tools ist viel besser, da die Struktur der Plattform den Aufbau eines hochwertigen Data Warehousing-Systems vereinfacht.

Auf dem Markt sind verschiedene ETL-Tools erhältlich, die sehr häufig verwendet werden. Einige von ihnen sind:

Unter all diesen Tools werde ich in diesem Talend ETL-Blog darüber sprechen, wie Talend als ETL-Tool fungiert.

Talend ETL Tool

Talend Open Studio für Datenintegration ist eines der leistungsstärksten ETL-Tools für die Datenintegration auf dem Markt. Mit TOS können Sie alle am ETL-Prozess beteiligten Schritte vom ersten ETL-Entwurf bis zur Ausführung des ETL-Datenladens einfach verwalten. Dieses Tool wurde in der grafischen Entwicklungsumgebung von Eclipse entwickelt. Talend Open Studio bietet Ihnen die grafische Umgebung, in der Sie die Daten zwischen der Quelle und dem Zielsystem einfach zuordnen können. Sie müssen lediglich die erforderlichen Komponenten aus der Palette in den Arbeitsbereich ziehen und dort ablegen, konfigurieren und schließlich miteinander verbinden. Es bietet Ihnen sogar ein Metadaten-Repository, in dem Sie Ihre Arbeit problemlos wiederverwenden und wiederverwenden können. Dies wird Ihnen definitiv helfen, Ihre Effizienz und Produktivität im Laufe der Zeit zu steigern.

Daraus können Sie schließen, dass Talend Open Studio für DI eine improvisierte Datenintegration sowie eine starke Konnektivität, einfache Anpassungsfähigkeit und einen reibungslosen Ablauf des Extraktions- und Transformationsprozesses bietet.

Im nächsten Abschnitt dieses Talend ETL-Blogs erfahren Sie, wie Sie den ETL-Prozess in Talend ausführen können.Talend Open Studio: Ausführen eines ETL-Jobs

Um den ETL-Prozess zu demonstrieren, extrahiere ich Daten aus einer Excel-Datei und transformiere sie durch Anwenden eines Filterszudie Daten und dann die neuen Daten in eine Datenbank laden. Folgendes ist das Format meines Excel-Datensatzes:

Aus diesem Datensatz werde ich die Datenzeilen basierend auf dem Kundentyp herausfiltern und sie jeweils in einer anderen Datenbanktabelle speichern. Führen Sie dazu die folgenden Schritte aus:

SCHRITT 1: Erstellen Sie einen neuen Job und ziehen Sie aus der Palette die folgenden Komponenten per Drag & Drop:- tMysqlConnection

- tFileExcelInput

- tReplizieren

- (( tFilterRow ) X4

- (( tMysqlOutput ) X4

SCHRITT 2: Verbinden Sie die Komponenten wie folgt:

SCHRITT 3: Wechseln Sie zur Registerkarte 'Komponente' von tMysqlConnection und wählen Sie unter 'Eigenschaftstyp' aus, welchen Verbindungstyp Sie 'Integriert' oder 'Repository' verwenden. Wenn Sie eine integrierte Verbindung verwenden, müssen Sie die folgenden Details angeben:- Gastgeber

- Hafen

- Datenbank

- Nutzername

- Passwort

Wenn Sie jedoch eine Repository-Verbindung verwenden, werden die Details standardmäßig aus dem Repository abgerufen.

SCHRITT 4: Doppelklicken Sie auf tFileInputExcel und geben Sie auf der Registerkarte 'Komponente' den Pfad Ihrer Quelldatei, die Anzahl der für den Header verwendeten Zeilen im Feld 'Header' und die Nummer der Spalte an, von der aus Talend Ihre Daten in der ersten Spalte lesen soll ' Feld. Entwerfen Sie im Schema 'Schema bearbeiten' das Schema entsprechend Ihrer Dataset-Datei.

SCHRITT 5 ::Klicken Sie auf der Registerkarte 'Komponenten' von tReplicate auf 'Spalten synchronisieren'.

SCHRITT 6: Wechseln Sie zur Registerkarte Komponente der ersten tFilterRow und überprüfen Sie das Schema. Abhängig von Ihrer Bedingung können Sie die Spalte (n) auswählen und die Funktion, den Operator und den Wert angeben, nach dem Daten gefiltert werden sollen.

SCHRITT 7: Wiederholen Sie dies für alle tFilterRow-Komponenten.SCHRITT 8: Aktivieren Sie schließlich auf der Registerkarte 'Komponente' von tMysqlOutput das Kontrollkästchen 'Vorhandene Verbindung verwenden'. Geben Sie dann den Tabellennamen in das Feld 'Tabelle' ein und wählen Sie je nach Anforderung 'Aktion auf Tabelle' und 'Aktion auf Daten' aus.

SCHRITT 9: Wiederholen Sie das gleiche für alle tMysqlOutput-Komponenten.SCHRITT 10: Wechseln Sie anschließend zur Registerkarte 'Ausführen' und führen Sie den Job aus.

Dies bringt uns zum Ende dieses Blogs über Talend ETL. Ich würde diesen Blog mit einem einfachen Gedanken abschließen, dem Sie folgen müssen:

'Die Zukunft gehört denen, die ihre Daten kontrollieren können'

Was bedeutet tostring in Java?

Wenn Sie diese Talend ETL gefunden haben Blog, relevant, Besuche die von Edureka, einem vertrauenswürdigen Online-Lernunternehmen mit einem Netzwerk von mehr als 250.000 zufriedenen Lernenden auf der ganzen Welt. Der Edureka Talend für DI- und Big Data-Zertifizierungskurs hilft Ihnen dabei, die Talend- und Big Data-Integrationsplattform zu beherrschen und alle Ihre Daten einfach in Ihr Data Warehouse und Ihre Anwendungen zu integrieren oder Daten zwischen Systemen zu synchronisieren. Hast du eine Frage an uns? Bitte erwähnen Sie es in den Kommentaren und wir werden uns bei Ihnen melden.