ist ein wichtiges Anliegen im Umgang mit vertraulichen Daten. Das gleiche Problem besteht auch darin, der Vorgesetzte bei Datenverarbeitungsvorgängen zu sein. Es verfügt nicht über eine eigene Sicherheit. Lassen Sie uns verstehen, wie das Problem dadurch gelöst wurde Hadoop-Sicherheit Artikel.

Warum brauchen wir Hadoop Security?

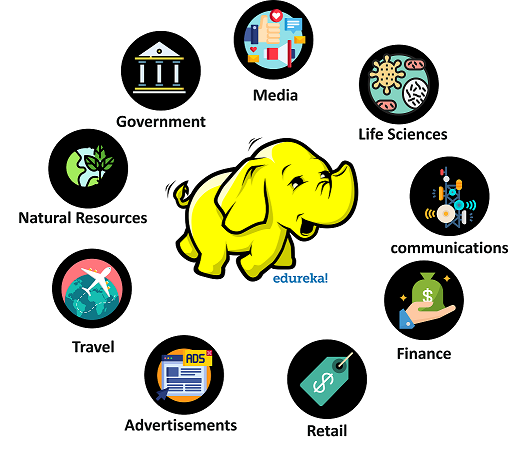

ist das leistungsstärkste, robusteste und am besten skalierbare Framework für die Verarbeitung großer Datenmengen Crunch Petabyte an Daten mit Leichtigkeit. Aufgrund seiner unübertroffenen Fähigkeiten nutzten damals alle Unternehmensbereiche, Gesundheits-, Militär- und Finanzabteilungen Hadoop.

Hadoop begann an Popularität zu gewinnen. Zu diesem Zeitpunkt fanden die Hadoop-Entwickler eine monumentale Fehleinschätzung. Hadoop fehlte eine spezielle Sicherheitssoftware im Inneren. Dies betraf viele Bereiche, in denen Hadoop eingesetzt wurde.

Mehrere Geschäftsbereiche

Nationale Sicherheit

Gesundheits- und medizinische Abteilungen

Sozialen Medien

Militär

Die oben genannten Bereiche sind die Hauptnutzer von Hadoop. Jetzt, Sicherheit ist der große Sprung, den Hadoop machen muss.

Was ist Hadoop-Sicherheit?

Hadoop-Sicherheit wird allgemein als Verfahren zu definiert sichern die Hadoop-Datenspeichereinheit, die eine praktisch undurchdringliche Schutzwand gegen potenzielle Cyber-Bedrohungen bietet. Hadoop erreicht diese hochkarätige Sicherheitswand, indem er die folgenden Schritte ausführt Sicherheitsprotokoll.

Authentifizierung

c ++ sort ()

Authentifizierung Dies ist die erste Phase, in der die Anmeldeinformationen des Benutzers überprüft werden. Die Anmeldeinformationen umfassen normalerweise die dedizierten Anmeldeinformationen des Benutzers Nutzername und ein geheimes Passwort. Trat einAnmeldeinformationen werden mit den verfügbaren Details in der Sicherheitsdatenbank verglichen. Wenn gültig, wird der Benutzer sein authentifiziert.

Genehmigung

Genehmigung Dies ist die zweite Phase, in der das System entscheiden kann, ob dem Benutzer die Berechtigung erteilt wird, auf Daten zuzugreifen oder nicht. Es basiert auf der vordefinierten Zugriffssteuerungsliste. Das VertraulicheInformationen werden sicher und nur aufbewahrt Authorisiertes Personal kann darauf zugreifen.

Prüfung

Prüfung In der letzten Phase werden lediglich die Vorgänge verfolgt, die der authentifizierte Benutzer während des Zeitraums ausgeführt hat, in dem er im Cluster angemeldet war. Das istausschließlich für gemacht Sicherheit nur zu Zwecken.

Arten von Hadoop-Sicherheit

- Kerberos-Sicherheit

Kerberos ist eines der führenden Netzwerkauthentifizierungsprotokolle, das leistungsstarke Authentifizierungsdienste für beide bereitstellt Server und Client-endet durch Geheimer Schlüssel Kryptographietechniken. Es hat sich als äußerst sicher erwiesen, da während der gesamten Sitzung verschlüsselte Servicetickets verwendet werden.

- HDFS-Verschlüsselung

HDFS-Verschlüsselung ist ein beeindruckender Fortschritt, den Hadoop jemals angenommen hat. Hier die Daten von Quelle zu Ziel (HDFS) wird vollständig verschlüsselt. Für dieses Verfahren müssen keine Änderungen an der ursprünglichen Hadoop-Anwendung vorgenommen werden Klient das einzige autorisierte Personal zu sein Zugriff die Daten.

Verkehrsverschlüsselung

Verkehrsverschlüsselung ist kein anderer als HTTPS (HyperText Transfer Protocol Secure). Dieses Verfahren dient zur Sicherung der Datenübertragung. von der Website ebenso gut wie Datenübertragung auf die Website . Viele Online-Banking-Gateways verwenden diese Methode, um Transaktionen über eine zu sichern Sicherheitszertifikat

HDFS-Datei- und Verzeichnisberechtigungen

HDFS-Dateiverzeichnisberechtigungen arbeiten in einem einfachen POSIX Format. Das Lesen und Schreiben Berechtigungen werden bereitgestellt als r und s beziehungsweise. Die Berechtigungen zum Super User und Klient werden je nach Vertraulichkeit der Datei unterschiedlich eingestellt.

Kerberos

Kerberos ist eines der einfachsten und sichersten Netzwerke Authentifizierungsprotokoll wird von Hadoop für seine Daten- und Netzwerksicherheit verwendet. Es wurde von erfunden MIT. Das Hauptziel von Kerberos besteht darin, die Notwendigkeit des Austauschs von Passwörtern über ein Netzwerk zu beseitigen und das Netzwerk vor potenziellen Problemen zu schützen Cyber-Schnüffeln.

Um die Kerberos-Terminologie zu verstehen, müssen wir uns zunächst mit den Komponenten der Kerberos-Software vertraut machen.

KDC oder Key Distribution Center ist das Herz von Kerberos. Es besteht hauptsächlich aus drei Komponenten. Nämlich:

Datenbank

Das Datenbank speichert die Benutzeranmeldeinformationen wie Nutzername und seine jeweiligen Passwörter. Es speichert auch die Zugriffsrechte dem Benutzer zur Verfügung gestellt. Kerberos KDC-Einheit speichert auch zusätzliche Informationen wie Verschlüsselungsschlüssel, Ticketgültigkeit usw.

Authentifizierungsserver

Die eingegebenen Benutzeranmeldeinformationen werden überprüft. Wenn gültig, die Authentifizierungsserver wird zur Verfügung stellen TGT oder Ticket Generation Ticket. Ein TGT kann nur generiert werden, wenn der Benutzer eingibt gültige Anmeldeinformationen.

Ticket Granting Server

Die nächste Stufe ist die TGS oder Ticket Granting Server. Es ist im Grunde ein Anwendungsserver von KDC, der Ihnen die zur Verfügung stellt Serviceticket. Das Serviceticket wird vom Benutzer benötigt, um mit Hadoop zu interagieren und den von ihm benötigten Service zu erhalten oder um eine Operation auf Hadoop auszuführen.

Sie können Kerberos mit dem folgenden Befehl installieren:

sudo apt-get install krb5-kdc krb5-admin-server

Nehmen wir nun an, Sie möchten auf einen Kerberos-gesicherten Hadoop-Cluster zugreifen. Sie müssen die folgenden Schritte ausführen, um auf den Hadoop-Cluster zuzugreifen, wie in den folgenden Schritten beschrieben:

Sie müssen erhalten Authentifizierung des Hadoop-Clusters. Sie können sich durch Ausführen authentifizieren lassen Kinit Befehl im Hadoop-Cluster.

kinit root / admin

Das Kinit Die Befehlsausführung leitet Sie zu weiter Anmeldedaten Seite, auf der Sie voraussichtlich Ihre eingeben Nutzername und Passwort.

Das Kinit wird eine senden Authentifizierungsanforderung zum Authentifizierungsserver.

Wenn Ihre Anmeldeinformationen sind gültig, dann antwortet Authentication Server mit einem Ticket Generation Ticket (TGT).

Java Unterschied zwischen implementiert und erweitert

Das Kinit wird die speichern TGT in Ihren Anmeldeinformationen Zwischenspeicher Erinnerung. Der folgende Befehl hilft Ihnen beim Lesen Ihrer Anmeldeinformationen

klist

Jetzt sind Sie erfolgreich in der authentifiziert KDS.

Bevor Sie auf den Hadoop-Cluster zugreifen können, müssen Sie Kerberos-Clients einrichten. Verwenden Sie dazu den folgenden Befehl.

sudo apt-get install krb5-user libpam-krb5 libpam-ccreds auth-client-config

Nun versuchen Sie, a auszuführen Hadoop-Befehl. Das ist ein Hadoop-Client.

Das Hadoop-Client wird deine verwenden TGT und Anfragen TGS zur Genehmigung.

Das TGS wird die Anfrage genehmigen und Ihnen eine Serviceticket.

Dies Serviceticket wird von der zwischengespeichert Hadoop-Client.

Dies Serviceticket wird vom Hadoop Client verwendet kommunizieren mit Hadoop Namenode.

Das Namenode wird sich mit seinem identifizieren Fahrkarte.

Beide Namenode Ticket und Hadoop Client Service-Tickets werden voneinander abgeglichen.

Beide sind sich sicher, dass sie mit einem kommunizieren authentifizierte Entität.

Das nennt man Gegenseitige Authentifizierung.

Die nächste Stufe ist Genehmigung. Der Namenode stellt Ihnen die zur Verfügung Bedienung für die Sie die erhalten haben Genehmigung.

Schließlich ist die letzte Stufe Prüfung. Hier dein Aktivität wird sein protokolliert zum Sicherheitsgründe.

Damit sind wir am Ende dieses Artikels angelangt . Ich hoffe, ich habe etwas Licht auf Ihr Wissen über a geworfen Hadoop-Sicherheit.

Nachdem Sie Hadoop und seine Sicherheit verstanden haben, lesen Sie die von Edureka, einem vertrauenswürdigen Online-Lernunternehmen mit einem Netzwerk von mehr als 250.000 zufriedenen Lernenden auf der ganzen Welt. Der Edureka Big Data Hadoop-Zertifizierungskurs hilft Lernenden, Experten für HDFS, Garn, Karte verkleinern , Pig, Hive, HBase, Oozie, Flume und Sqoop verwenden Echtzeit-Anwendungsfälle für den Bereich Einzelhandel, soziale Medien, Luftfahrt, Tourismus und Finanzen.

Wenn Sie Fragen dazu haben 'Hadoop-Sicherheit' Artikel, dann schreiben Sie uns bitte im Kommentarbereich unten und wir werden Ihnen so früh wie möglich antworten.