Apache Hive ist eines der wichtigsten Frameworks im Hadoop-Ökosystem, was es wiederum sehr wichtig macht . In diesem Blog erfahren Sie mehr über die Installation von Apache Hive und Hive unter Ubuntu.

Was ist Apache Hive?

Apache Hive ist eine Data Warehouse-Infrastruktur, die das Abfragen und Verwalten großer Datenmengen erleichtert, die sich in einem verteilten Speichersystem befinden. Es basiert auf Hadoop und wurde von Facebook entwickelt. Bienenstock bietet eine Möglichkeit zum Abfragen der Daten mithilfe einer SQL-ähnlichen Abfragesprache namens HiveQL (Hive Query Language).

Intern übersetzt ein Compiler HiveQL Aussagen in Karte verkleinern Jobs, die dann an gesendet werden Hadoop-Framework zur Ausführung.

Unterschied zwischen Hive und SQL:

Bienenstock sieht sehr ähnlich aus wie herkömmliche Datenbank mit SQL Zugriff. Allerdings, weil Bienenstock basiert auf Hadoop und Karte verkleinern Operationen gibt es mehrere wesentliche Unterschiede:

Da Hadoop für lange sequentielle Scans gedacht ist und Bienenstock basiert auf Hadoop würden Sie erwarten, dass Abfragen eine sehr hohe Latenz haben. Das heißt das Bienenstock Dies ist nicht für Anwendungen geeignet, die sehr schnelle Antwortzeiten benötigen, wie dies bei einer herkömmlichen RDBMS-Datenbank zu erwarten ist.

Schließlich, Bienenstock ist lesebasiert und daher nicht für die Transaktionsverarbeitung geeignet, bei der normalerweise ein hoher Prozentsatz der Schreibvorgänge erforderlich ist.

wie man eine Zahl in Python in Binär umwandelt

Hive-Installation unter Ubuntu:

Befolgen Sie zur Installation die folgenden Schritte Apache Hive unter Ubuntu:

Schritt 1: Herunterladen Bienenstock Teer.

Befehl: wget http://archive.apache.org/dist/hive/hive-2.1.0/apache-hive-2.1.0-bin.tar.gz

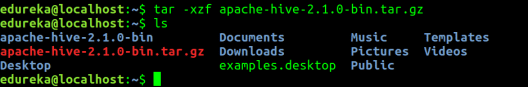

Schritt 2: Extrahieren Sie die Teer Datei.

Befehl: tar -xzf apache-hive-2.1.0-bin.tar.gz

Befehl: ls

Schritt 3: Bearbeiten Sie die '.Bashrc' Datei zum Aktualisieren der Umgebungsvariablen für den Benutzer.

Befehl: sudo gedit .bashrc

Fügen Sie am Ende der Datei Folgendes hinzu:

# Setzen Sie HIVE_HOME

exportiere HIVE_HOME = / home / edureka / apache-hive-2.1.0-bin

export PATH = $ PATH: /home/edureka/apache-hive-2.1.0-bin/bin

Stellen Sie außerdem sicher, dass auch der Hadoop-Pfad festgelegt ist.

Führen Sie den folgenden Befehl aus, damit die Änderungen im selben Terminal funktionieren.

Befehl: Quelle .bashrc

Schritt 4: Überprüfen Sie die Hive-Version.

verbundene und nicht verbundene Transformation in der Informatik

Schritt 5: Erstellen Bienenstock Verzeichnisse innerhalb HDFS . Das Verzeichnis 'Warenhaus' ist der Speicherort für die Tabelle oder die Daten in Bezug auf den Bienenstock.

Befehl:

- hdfs dfs -mkdir -p / user / hive / warehouse

- hdfs dfs -mkdir / tmp

Schritt 6: Legen Sie Lese- / Schreibberechtigungen für die Tabelle fest.

Befehl:

In diesem Befehl erteilen wir der Gruppe Schreibberechtigung:

- hdfs dfs -chmod g + w / user / hive / warehouse

- hdfs dfs -chmod g + w / tmp

Schritt 7: einstellen Hadoop Pfad in h ive-env.sh

Befehl: cd apache-hive-2.1.0-bin /

Befehl: gedit conf / hive-env.sh

Stellen Sie die Parameter wie im folgenden Schnappschuss gezeigt ein.

Schritt 8: Bearbeiten hive-site.xml

Befehl: gedit conf / hive-site.xml

javax.jdo.option.ConnectionURL jdbc: derby: databaseName = / home / edureka / apache-hive-2.1.0-bin / metastore_dbcreate = true JDBC-Verbindungszeichenfolge für einen JDBC-Metastore. Um SSL zum Verschlüsseln / Authentifizieren der Verbindung zu verwenden, geben Sie in der Verbindungs-URL ein datenbankspezifisches SSL-Flag an. Beispiel: jdbc: postgresql: // myhost / db? Ssl = true für die Postgres-Datenbank. hive.metastore.warehouse.dir / user / hive / warehouse Speicherort der Standarddatenbank für das Warehouse hive.metastore.uris Thrift-URI für den Remote-Metastore. Wird vom Metastore-Client verwendet, um eine Verbindung zum Remote-Metastore herzustellen. javax.jdo.option.ConnectionDriverName org.apache.derby.jdbc.EmbeddedDriver Treiberklassenname für einen JDBC-Metastore javax.jdo.PersistenceManagerFactoryClass org.datanucleus.api.jdo.JDOPersistenceManagerFactory-Klasse, die die jdo-Persistenz implementiert

Schritt 9: Standardmäßig verwendet Hive Derby Datenbank. Derby-Datenbank initialisieren.

überschreiben vs überladen c ++

Befehl: bin / schematool -initSchema -dbType Derby

Schritt 10 ::Starten Bienenstock.

Befehl: Bienenstock

Schritt 11 ::Führen Sie einige Abfragen in der Hive-Shell aus.

Befehl: Datenbanken anzeigen

Befehl: Erstellen von Tabellenmitarbeitern (ID-Zeichenfolge, Namenszeichenfolge, Abteilungszeichenfolge) Zeilenformat-getrennte Felder, die durch '' als Textdatei gespeichert sind

Befehl: Tabellen anzeigen

Schritt 12: Verlassen Bienenstock:

Befehl: Ausfahrt

Nachdem Sie mit der Installation von Hive fertig sind, besteht der nächste Schritt darin, Hive-Befehle in der Hive-Shell auszuprobieren. Daher unser nächster Blog “ Top Hive-Befehle mit Beispielen in HQL ”Hilft Ihnen, Hive-Befehle zu meistern.

Zusammenhängende Posts: