HDFS 2.x-Hochverfügbarkeitsclusterarchitektur

In diesem Blog werde ich über die HDFS 2.x-Hochverfügbarkeitsclusterarchitektur und das Verfahren zum Einrichten eines HDFS-Hochverfügbarkeitsclusters sprechen.Dies ist ein wichtiger Teil der . Die Reihenfolge, in der die Themen in diesem Blog behandelt wurden, ist wie folgt:

- HDFS HA-Architektur

- Einführung

- NameNode Verfügbarkeit

- Architektur von HA

- Implementierung von HA (JournalNode und Shared Storage)

- Wie richte ich HA (Quorum Journal Nodes) in einem Hadoop-Cluster ein?

Einführung:

Das Konzept des Hochverfügbarkeitsclusters wurde in Hadoop 2 eingeführt.x, um das Single Point of Failure-Problem in Hadoop 1.x zu lösen. Wie Sie aus meinem vorherigen Blog wissen, dass die folgt der Master / Slave-Topologie, wobei NameNode als Master-Daemon fungiert und für die Verwaltung anderer Slave-Knoten namens DataNodes verantwortlich ist. Dieser einzelne Master Daemon oder NameNode wird zu einem Engpass. Die Einführung von Secondary NameNode hat uns zwar daran gehindert, Daten zu verlieren und einen Teil der Last des NameNode zu entlasten, das Verfügbarkeitsproblem des NameNode jedoch nicht gelöst.

NameNode Verfügbarkeit:

Wenn Sie die Standardkonfiguration des HDFS-Clusters berücksichtigen, wird der NameNode zu a der Punkt des Versagens . Dies geschieht, weil in dem Moment, in dem der NameNode nicht mehr verfügbar ist, der gesamte Cluster nicht mehr verfügbar ist, bis jemand den NameNode neu startet oder einen neuen bringt.

Die Gründe für die Nichtverfügbarkeit von NameNode können sein:

- Ein geplantes Ereignis wie Wartungsarbeiten wie die Aktualisierung von Software oder Hardware.

- Dies kann auch auf ein ungeplantes Ereignis zurückzuführen sein, bei dem der NameNode aus bestimmten Gründen abstürzt.

In beiden Fällen haben wir eine Ausfallzeit, in der wir den HDFS-Cluster nicht verwenden können, was zu einer Herausforderung wird.

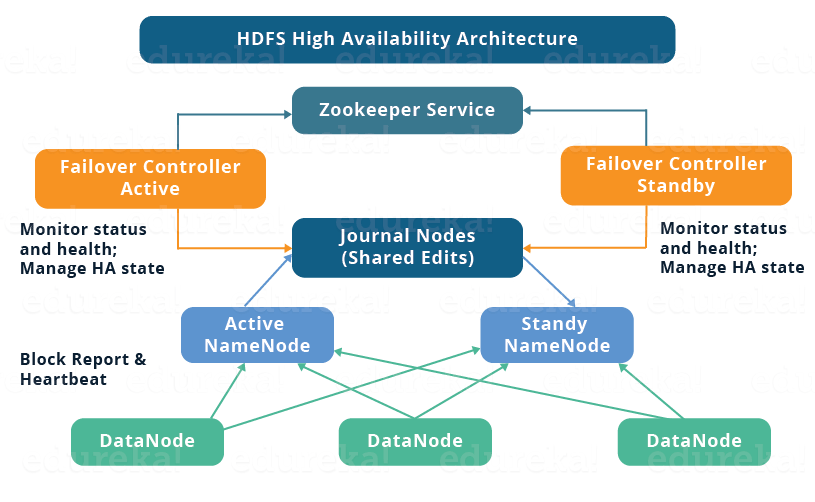

HDFS HA-Architektur:

Lassen Sie uns verstehen, wie die HDFS HA-Architektur dieses kritische Problem der Verfügbarkeit von NameNode gelöst hat:

Die HA-Architektur löste dieses Problem der Verfügbarkeit von NameNode, indem wir zwei NameNodes in einer aktiven / passiven Konfiguration haben konnten. In einem Hochverfügbarkeitscluster werden also zwei NameNodes gleichzeitig ausgeführt:

- Aktiver NameNode

- Standby / Passiver NameNode.

Wenn ein NameNode ausfällt, kann der andere NameNode die Verantwortung übernehmen und somit die Ausfallzeit des Clusters reduzieren. Der Standby-NameNode dient als Backup-NameNode (im Gegensatz zum sekundären NameNode), der Failover-Funktionen für den Hadoop-Cluster enthält. Daher können wir mit dem StandbyNode ein automatisches Failover durchführen, wenn ein NameNode abstürzt (ungeplantes Ereignis), oder während des Wartungszeitraums ein ordnungsgemäßes (manuell initiiertes) Failover durchführen.

Es gibt zwei Probleme bei der Aufrechterhaltung der Konsistenz im HDFS-Hochverfügbarkeitscluster:

- Active und Standby NameNode sollten immer miteinander synchron sein, d. H. Sie sollten dieselben Metadaten haben. Auf diese Weise können wir den Hadoop-Cluster auf den gleichen Namespace-Status zurücksetzen, in dem er abgestürzt ist, und somit ein schnelles Failover durchführen.

- Es sollte immer nur ein aktiver NameNode vorhanden sein, da zwei aktive NameNode zu einer Beschädigung der Daten führen. Diese Art von Szenario wird als Split-Brain-Szenario bezeichnet, bei dem ein Cluster in kleinere Cluster unterteilt wird, von denen jeder glaubt, dass es der einzige aktive Cluster ist. Um solche Szenarien zu vermeiden, wird eingezäunt. Beim Fechten wird sichergestellt, dass zu einem bestimmten Zeitpunkt nur ein NameNode aktiv bleibt.

Implementierung der HA-Architektur:

Jetzt wissen Sie, dass in der HDFS HA-Architektur zwei NameNodes gleichzeitig ausgeführt werden. Daher können wir die Active- und Standby-NameNode-Konfiguration auf zwei Arten implementieren:

- Verwenden von Quorum-Journal-Knoten

- Shared Storage mit NFS

Lassen Sie uns diese beiden Implementierungsmethoden nacheinander verstehen:

1. Verwenden von Quorum-Journal-Knoten:

- Der Standby-NameNode und der aktive NameNode bleiben über eine separate Gruppe von Knoten oder Daemons, die aufgerufen werden, miteinander synchron JournalNodes .Die JournalNodes folgen der Ringtopologie, bei der die Knoten miteinander verbunden sind, um einen Ring zu bilden.Der JournalNode bedient die zu ihm kommende Anforderung und kopiert die Informationen in andere Knoten im Ring.Dies bietet Fehlertoleranz bei einem JournalNode-Fehler.

- Der aktive NameNode ist für die Aktualisierung der in den JournalNodes vorhandenen EditLogs (Metadateninformationen) verantwortlich.

- Der StandbyNode liest die an den EditLogs im JournalNode vorgenommenen Änderungen und wendet sie konstant auf seinen eigenen Namespace an.

- Während des Failovers stellt der StandbyNode sicher, dass er seine Metadateninformationen aus den JournalNodes aktualisiert hat, bevor er zum neuen Active NameNode wird. Dadurch wird der aktuelle Namespace-Status mit dem Status vor dem Failover synchronisiert.

- Die IP-Adressen beider NameNodes stehen allen DataNodes zur Verfügung und senden ihre Heartbeat- und Block-Standortinformationen an beide NameNode. Dies bietet ein schnelles Failover (weniger Ausfallzeiten), da der StandbyNode über aktualisierte Informationen zum Blockspeicherort im Cluster verfügt.

Fechten von NameNode:

Wie bereits erwähnt, ist es jetzt sehr wichtig sicherzustellen, dass jeweils nur ein aktiver NameNode vorhanden ist. Fencing ist also ein Prozess, um genau diese Eigenschaft in einem Cluster sicherzustellen.

- Die JournalNodes führen dieses Fencing durch, indem jeweils nur ein NameNode als Writer zugelassen wird.

- Der Standby-NameNode übernimmt die Verantwortung für das Schreiben in die JournalNodes und verbietet jedem anderen NameNode, aktiv zu bleiben.

- Schließlich kann der neue Active NameNode seine Aktivitäten sicher ausführen.

2. Verwenden von Shared Storage:

- Der StandbyNode und der aktive NameNode bleiben unter Verwendung von a miteinander synchron gemeinsam genutztes Speichergerät .Der aktive NameNode protokolliert den Datensatz aller in seinem Namespace vorgenommenen Änderungen in einem EditLog, das in diesem gemeinsam genutzten Speicher vorhanden ist.Der StandbyNode liest die an den EditLogs in diesem gemeinsam genutzten Speicher vorgenommenen Änderungen und wendet sie auf seinen eigenen Namespace an.

- Im Falle eines Failovers aktualisiert der StandbyNode seine Metadateninformationen zunächst mithilfe der EditLogs im gemeinsam genutzten Speicher. Dann übernimmt es die Verantwortung des Active NameNode. Dadurch wird der aktuelle Namespace-Status mit dem Status vor dem Failover synchronisiert.

- Der Administrator muss mindestens eine Fencing-Methode konfigurieren, um ein Split-Brain-Szenario zu vermeiden.

- Das System kann eine Reihe von Zaunmechanismen verwenden. Dies kann das Beenden des Namensknotenprozesses und das Widerrufen des Zugriffs auf das freigegebene Speicherverzeichnis umfassen.

- Als letzten Ausweg können wir den zuvor aktiven NameNode mit einer als STONITH bekannten Technik umzäunen oder „den anderen Knoten in den Kopf schießen“. STONITH verwendet eine spezielle Stromverteilungseinheit, um die NameNode-Maschine zwangsweise auszuschalten.

Automatisches Failover:

Failover ist ein Verfahren, mit dem ein System die Steuerung automatisch an das sekundäre System überträgt, wenn es einen Fehler oder eine Störung erkennt. Es gibt zwei Arten von Failover:

Graceful Failover: In diesem Fall initiieren wir das Failover manuell für die routinemäßige Wartung.

Automatisches Failover: In diesem Fall wird das Failover bei einem NameNode-Fehler (ungeplantes Ereignis) automatisch initiiert.

Apache Zookeeper ist ein Dienst, der die automatische Failover-Funktion in HDFS-Hochverfügbarkeitsclustern bereitstellt. Es verwaltet kleine Mengen an Koordinationsdaten, informiert Kunden über Änderungen dieser Daten und überwacht Kunden auf Fehler. Zookeeper unterhält eine Sitzung mit den NameNodes. Im Fehlerfall läuft die Sitzung ab und der Zookeeper informiert andere NameNodes, um den Failover-Prozess zu starten. Im Falle eines NamensNode-Fehlers kann ein anderer passiver NameNode eine Sperre in Zookeeper vornehmen, die angibt, dass er der nächste aktive NameNode werden soll.

Der ZookeerFailoverController (ZKFC) ist ein Zookeeper-Client, der auch den NameNode-Status überwacht und verwaltet. Jeder NameNode führt auch eine ZKFC aus. ZKFC ist für die regelmäßige Überwachung des Zustands der NameNodes verantwortlich.

Nachdem Sie die Hochverfügbarkeit in einem Hadoop-Cluster verstanden haben, ist es an der Zeit, sie einzurichten. Um die Hochverfügbarkeit im Hadoop-Cluster einzurichten, müssen Sie Zookeeper in allen Knoten verwenden.

Die Daemons in Active NameNode sind:

- Tierpfleger

- Zookeeper Failover-Controller

- JournalNode

- NameNode

Die Daemons in Standby NameNode sind:

- Tierpfleger

- Zookeeper Failover-Controller

- JournalNode

- NameNode

Die Daemons in DataNode sind:

- Tierpfleger

- JournalNode

- DataNode

Wenn Sie HDFS und Hadoop beherrschen möchten, lesen Sie den speziell kuratierten Big Data- und Hadoop-Kurs von Edureka. Klicken Sie auf die Schaltfläche unten, um loszulegen.

Einrichten und Konfigurieren eines Hochverfügbarkeitsclusters in Hadoop:

Sie müssen zuerst die Java- und Hostnamen jedes Knotens einrichten.

| Virtuelle Maschine | IP Adresse | Hostname |

| Aktiver NameNode | 192.168.1.81 | nn1.cluster.com oder nn1 |

| Standby NameNode | 192.168.1.58 | nn2.cluster.com oder nn2 |

| DataNode | 192.168.1.82 | dn1.cluster.com oder dn1 |

Laden Sie die binäre Tar-Datei von Hadoop und Zookeeper herunter und extrahieren Sie die Dateien, um die Konfigurationsdateien zu bearbeiten.

Befehl : wget https://archive.apache.org/dist/zookeeper/zookeeper-3.4.6/zookeeper-3.4.6.tar.gz

Verbreiten Sie den Tierpfleger-3.4.6.tar.gz

Befehl : tar –xvf zookeeper-3.4.6.tar.gz

Laden Sie den stabilen binären Hadoop-Teer von der Apache Hadoop-Site herunter.

Befehl : wget https://archive.apache.org/dist/hadoop/core/hadoop-2.6.0/hadoop-2.6.0.tar.gz

Extrahieren Sie den Hadoop-Teerball.

Befehl : tar –xvf hadoop-2.6.0.tar.gz

Hadoop binär verbreiten.

Fügen Sie Hadoop, Zookeeper und Pfade zur .bashrc-Datei hinzu.

Öffnen Sie die .bashrc-Datei.

Befehl : sudo gedit ~ / .bashrc

Fügen Sie die folgenden Pfade hinzu:

Export HADOOP_HOME = Export HADOOP_MAPRED_HOME = $ HADOOP_HOME Export HADOOP_COMMON_HOME = $ HADOOP_HOME Export HADOOP_HDFS_HOME = $ HADOOP_HOME Export YARN_HOME = $ HADOOP_HOME Export HADOOP_CONF_DIR = $ HADOOP_HOME / etc / hadoop Export YARN_CONF_DIR = $ HADOOP_HOME / etc / hadoop export JAVA_HOME = Export ZOOKEEPER_HOME = export PATH = $ PATH: $ JAVA_HOME / bin: $ HADOOP_HOME / bin: $ HADOOP_HOME / sbin: $ ZOOKEEPER_HOME / binBearbeiten Sie die .bashrc-Datei.

Aktivieren Sie die SSH in allen Knoten.

Generieren Sie den SSH-Schlüssel in allen Knoten.

Befehl : ssh-keygen –t rsa (Dieser Schritt in allen Knoten)

Richten Sie den SSH-Schlüssel in allen Knoten ein.

Geben Sie keinen Pfad zur Eingabedatei an, um den Schlüssel zu speichern, und geben Sie keine Passphrase an. Drücken Sie die Eingabetaste.

Keyword-gesteuertes Framework in Selen

Generieren Sie den SSH-Schlüsselprozess in allen Knoten.

Sobald der SSH-Schlüssel generiert wurde, erhalten Sie den öffentlichen und den privaten Schlüssel.

Das .ssh-Schlüsselverzeichnis sollte die Berechtigung 700 enthalten, und alle Schlüssel im .ssh-Verzeichnis sollten die Berechtigungen 600 enthalten.

Ändern Sie die Berechtigung für das SSH-Verzeichnis.

Ändern Sie das Verzeichnis in .ssh und die Berechtigung von Dateien in 600

Ändern Sie die Berechtigung für öffentliche und private Schlüssel.

Sie müssen den öffentlichen Schlüssel ssh des Namensknotens auf alle Knoten kopieren.

Kopieren Sie in Active Namenode die Datei id_rsa.pub mit dem Befehl cat.

Befehl : cat ~ / .ssh / id_rsa.pub >> ~ / .ssh / autorisierte_Tasten

Kopieren Sie den Namenode-SSH-Schlüssel in die autorisierten Schlüssel.

Kopieren Sie den öffentlichen NameNode-Schlüssel mit auf alle Knoten ssh-copy-id Befehl.

Befehl : ssh-copy-id –i .ssh / id_rsa.pub edureka@nn2.cluster.com

MS SQL-Tutorials für Anfänger

Kopieren Sie den Zweckschlüssel in den Standby-Namensknoten.

Kopieren Sie den öffentlichen Schlüssel NameNode in den Datenknoten.

Befehl : ssh-copy-id –i .ssh / id_rsa.pub edureka@dn1.cluster.com

Kopieren Sie den öffentlichen Namenode-Schlüssel in den Datenknoten.

Starten Sie den sshd-Dienst in allen Knoten neu.

Befehl : sudo service sshd restart (In allen Knoten ausführen)

Starten Sie den SSH-Dienst neu.

Jetzt können Sie sich ohne Authentifizierung bei jedem Knoten von Namenode aus anmelden.

Öffnen Sie die Datei core-site.xml über den Knoten Active Name und fügen Sie die folgenden Eigenschaften hinzu.

Bearbeiten Sie die Datei core-site.xml im aktiven Namensknoten

Öffnen Sie die Datei hdfs-site.xml in Active Namenode. Fügen Sie die folgenden Eigenschaften hinzu.

dfs.namenode.name.dir / home / edureka / HA / data / namenode dfs.replication 1 dfs.permissions false dfs.nameservices ha-cluster dfs.ha.namenodes.ha-cluster nn1, nn2 dfs.namenode.rpc-address .ha-cluster.nn1 nn1.cluster.com:9000 dfs.namenode.rpc-address.ha-cluster.nn2 nn2.cluster.com:9000 dfs.namenode.http-address.ha-cluster.nn1 nn1.cluster. com: 50070 dfs.namenode.http-address.ha-cluster.nn2 nn2.cluster.com:50070 dfs.namenode.shared.edits.dir qjournal: //nn1.cluster.com: 8485nn2.cluster.com: 8485dn1. cluster.com:8485/ha-cluster dfs.client.failover.proxy.provider.ha-cluster org.apache.hadoop.hdfs.server.namenode.ha.ConfiguredFailoverProxyProvider dfs.ha.automatic-failover.enabled true ha.zookeeper .quorum nn1.cluster.com:2181,nn2.cluster.com:2181,dn1.cluster.com:2181 dfs.ha.fencing.methods sshfence dfs.ha.fencing.ssh.private-key-files / home / edureka /.ssh/id_rsaÄndern Sie das Verzeichnis in das conf-Verzeichnis von zookeeper.

Befehl : cd zookeeper-3.4.6 / conf

Zookeeper Conf-Verzeichnis.

Erstellen Sie in einem conf-Verzeichnis mit der Datei zoo_sample.cfg die Datei zoo.cfg mit der Datei zoo_sample.cfg.

Befehl : cp zoo_sample.cfg zoo.cfg

Erstellen Sie die Datei zoo.cfg.

Erstellen Sie das Verzeichnis an einem beliebigen Ort und speichern Sie die Tierpflegerdaten in diesem Verzeichnis.

Befehl : mkdir

Erstellen Sie ein Verzeichnis zum Speichern von Zookeeper-Daten.

Öffnen Sie die Datei zoo.cfg.

Befehl : gedit zoo.cfg

Fügen Sie den Verzeichnispfad, der im obigen Schritt erstellt wurde, zur Eigenschaft dataDir hinzu und fügen Sie die folgenden Details zum verbleibenden Knoten in die Datei zoo.cfg ein.

Server.1 = nn1.cluster.com: 2888: 3888

Server.2 = nn2.cluster.com: 2888: 3888

Server.3 = dn1.cluster.com: 2888: 3888

Bearbeiten Sie die Datei zoo.cfg.

Kopieren Sie nun die Verzeichnisse Java und Hadoop-2.6.0, zookeeper-3.4.6 und die .bashrc-Datei mit dem Befehl scp auf alle Knoten (Standby-Namensknoten, Datenknoten).

Befehl : scp –r edureka @:

Kopieren Sie die Hadoop-, Zookeeper- und .bashrc-Datei auf alle Knoten.

Kopieren Sie in ähnlicher Weise die .bashrc-Datei und das Zookeeper-Verzeichnis auf alle Knoten und ändern Sie die Umgebungsvariablen in jedem Knoten entsprechend dem jeweiligen Knoten.

Erstellen Sie in einem Datenknoten ein beliebiges Verzeichnis, in dem Sie die HDFS-Blöcke speichern müssen.

In einem Datenknoten müssen Sie die Eigenschaften dfs.datanode.data.dir hinzufügen.

In meinem Fall habe ich erstellt Datenknoten Verzeichnis zum Speichern der Blöcke.

Erstellen Sie ein Datenknotenverzeichnis.

Ändern Sie die Berechtigung in das Datenknotenverzeichnis.

Ändern Sie die Berechtigung für das Datanode-Verzeichnis.

Öffnen Sie die Datei HDFS-site.xml und fügen Sie diesen Datanode-Verzeichnispfad in die Eigenschaft dfs.datanode.data.dir ein.

Hinweis: Behalten Sie alle Eigenschaften bei, die aus dem aktiven Namensknoten kopiert wurden. Fügen Sie dfs.datanode.data.dir eine Extrakt-Eigenschaft im Namensknoten hinzu.

dfs.datanode.data.dir / home / edureka / HA / data / datanodeÄndern Sie unter Aktiver Namensknoten das Verzeichnis, in dem Sie die Zookeeper-Konfigurationsdatei speichern möchten (dataDir-Eigenschaftspfad).

Erstellen Sie die myid-Datei im Verzeichnis, fügen Sie der Datei die Nummer 1 hinzu und speichern Sie die Datei.

Befehl : vi myid

Erstellen Sie eine myid-Datei.

Ändern Sie in einem Standby-Namensknoten das Verzeichnis, in dem Sie die Zookeeper-Konfigurationsdatei speichern möchten (dataDir-Eigenschaftspfad).

Erstellen Sie die myid-Datei im Verzeichnis, fügen Sie der Datei die Nummer 2 hinzu und speichern Sie die Datei.

Ändern Sie in einem Datenknoten das Verzeichnis, in dem Sie die Zookeeper-Konfigurationsdatei speichern möchten (dataDir-Eigenschaftspfad).

Erstellen Sie die myid-Datei im Verzeichnis, fügen Sie der Datei die Nummer 3 hinzu und speichern Sie die Datei.

Starten Sie den Journalknoten in allen drei Knoten.

Befehl : hadoop-daemon.sh Startjournalknoten

Starten Sie den Journalknoten.

Wenn Sie den Befehl jps eingeben, wird der JournalNode-Dämon in allen Knoten angezeigt.

Formatieren Sie dieAktiver Zweck.

Befehl : HDFS beabsichtigt -format

Aktives NameNode-Format.

Starten Sie den Namenode-Daemon und Active Namedode.

Befehl : hadoop-daemon.sh Startzweck

Starten Sie Namenode.

Kopieren Sie die HDFS-Metadaten vom aktiven Namensknoten in den Standby-Namensknoten.

Befehl : HDFS beabsichtigt -bootstrapStandby

Kopieren Sie die HDFS-Metadaten vom aktiven Namensknoten in den Standby-Namenode.

Sobald Sie diesen Befehl ausführen, erhalten Sie Informationen darüber, von welchem Knoten und Speicherort die Metadaten kopiert werden und ob sie erfolgreich kopiert werden oder nicht.

Informationen zu Details des aktiven Zwecks.

Sobald die Metadaten vom aktiven Namensknoten in den Standby-Namensknoten kopiert wurden, wird die unten im Screenshot gezeigte Meldung angezeigt.

Informationen zu HDFS in Standby Namenode.

Starten Sie den Namenode-Daemon auf dem Standby-Namenode-Computer.

Befehl : hadoop-daemon.sh Startzweck

Starten Sie nun den Zookeeper-Dienst in allen drei Knoten.

Befehl : zkServer.sh start (Führen Sie diesen Befehl auf allen Knoten aus.)

In aktivem Zweck:

Starten Sie zookeeper in Active NameNode.

Im Standby-Namenode:

Starten Sie zookeeper im Standby-NameNode.

Im Datenknoten:

Starten Sie zookeeper in DataNode.

Geben Sie nach dem Ausführen des Zookeeper-Servers den Befehl JPS ein. In allen Knoten sehen Sie den QuorumPeerMain-Dienst.

Starten Sie den Datenknotendämon in der Datenknotenmaschine.

Befehl : hadoop-daemon.sh start datanode

Starten Sie den Zookeeper-Failover-Controller im Knoten Aktiver Name und Standby-Name.

Formatieren Sie den Zookeeper-Failover-Controller im aktiven Namensknoten.

Befehl: HDFS zkfc –formatZK

Formatieren Sie ZKFC.

Starten Sie die ZKFC im aktiven Namensknoten.

Befehl : hadoop-daemon.sh starte zkfc

Geben Sie den Befehl jps ein, um die DFSZkFailoverController-Dämonen zu überprüfen.

Starten Sie ZKFC.

Formatieren Sie den Zookeeper-Failover-Controller im Standby-Namensknoten.

Befehl : hdfs zkfc –formatZK

Starten Sie den ZKFC im Standby-Namensknoten.

Befehl : hadoop-daemon.sh starte zkfc

Geben Sie den Befehl jps ein, um die DFSZkFailoverController-Dämonen zu überprüfen.

Überprüfen Sie nun mit dem folgenden Befehl den Status jedes Namenodes, welcher Knoten aktiv ist oder welcher Knoten sich im Standby-Modus befindet.

Befehl : hdfs haadmin –getServiceState nn1

Überprüfen Sie den Status jedes NameNode.

Überprüfen Sie nun den Status jedes Namenodes mit dem Webbrowser.

Öffnen Sie den Webbrowser und geben Sie die folgende URL ein.

: 50070

Es wird angezeigt, ob der Namensknoten aktiv oder im Standby-Modus ist.

Aktiver NameNode.

Öffnen Sie mit dem Webbrowser Details zu einem anderen Namensknoten.

Standby NameNode.

Wie erstelle ich eine Singleton-Klasse in Java?

Beenden Sie im aktiven Namensknoten den Namensknoten-Daemon, um den Standby-Namensknoten in aktiven Namensknoten zu ändern.

Geben Sie jps in Active namenode ein und beenden Sie den Daemon.

Befehl: Sudo töten -9

Daemons Prozess-ID.

Die Namenode-Prozess-ID lautet 7606, töten Sie den Namensknoten.

Befehl : Sudo töten -9 7606

Beenden Sie den Prozess 'Namensknoten'

Öffnen Sie die beiden Knoten über den Webbrowser und überprüfen Sie den Status.

Namenode Details.

NameNode-Status.

Herzlichen Glückwunsch, Sie haben erfolgreich einen HDFS-Hochverfügbarkeitscluster in Hadoop eingerichtet.

Nachdem Sie die Hadoop-Hochverfügbarkeitsclusterarchitektur verstanden haben, lesen Sie die von Edureka, einem vertrauenswürdigen Online-Lernunternehmen mit einem Netzwerk von mehr als 250.000 zufriedenen Lernenden auf der ganzen Welt. Der Edureka Big Data Hadoop-Zertifizierungskurs hilft Lernenden, Experten für HDFS, Garn, MapReduce, Schwein, Bienenstock, HBase, Oozie, Flume und Sqoop zu werden. Dabei werden Anwendungsfälle in Echtzeit in den Bereichen Einzelhandel, soziale Medien, Luftfahrt, Tourismus und Finanzen verwendet.

Hast du eine Frage an uns? Bitte erwähnen Sie es in den Kommentaren und wir werden uns bei Ihnen melden.

window._LQ_ = window._LQ_ || {}

lqQuizModal (Fenster, Dokument, {quizId: 'XAIVp8', baseUrl: 'https: //quiz.leadquizzes.com/'trigger:' exit '}, _LQ_)